讯飞的星火,能否燎原AI大模型?

来自大洋彼岸硅谷的OpenAI,在2022年11月推出了聊天程序ChatGPT,引发了一场波及全球的科技“海啸”。

最新的入场者,是以“星火认知大模型”为名称的科大讯飞。 #科大讯飞#

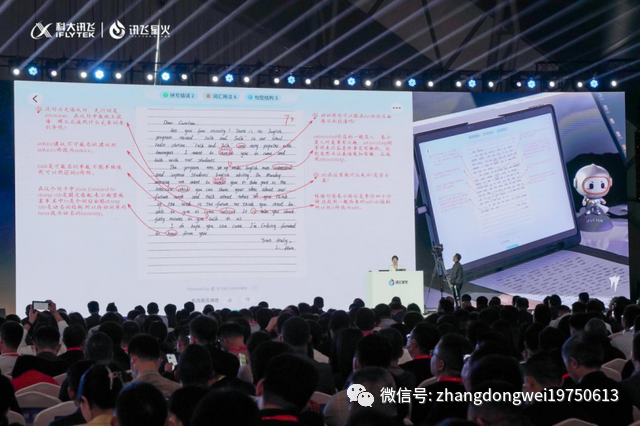

5月6日,讯飞星火认知大模型成果发布会在安徽合肥举行。

科大讯飞董事长刘庆峰、研究院院长刘聪发布讯飞星火认知大模型,现场实测大模型七大核心能力,并发布教育、办公、汽车、数字员工四大行业应用成果。讯飞星火认知大模型可基于自然语言对话方式实现多领域多任务的用户需求理解与任务执行。

根据讯飞星火认知大模型发布会现场展示的内容,它还能完成故事创作、中英转写、代码编程等高阶工作。

星星之火,何以燎原?如何让大模型赋能更多开发者,打造更具价值的应用?以讯飞星火大模型为引擎,以讯飞开放平台为依托,共建人工智能「星火」生态,将是“燎原”的必经之路。

仅仅6个月时间里,中国几乎所有的知名的科技企业,都发布了类ChatGPT的“AI大模型”。

这其中,最为受关注的,当属百度的“文心一言”,阿里的“通义千问”,商汤科技的“日日新”和科大讯飞的“星火”。

作者张栋伟之所以如此认为,是因为在ChatGPT火爆之初,就曾经公开发文指出,AI大模型要能跑出,至少需要同时具备三个基础条件:数据、算力和场景。

1、数据

数据不仅仅是数量的问题,还有来源的问题。

中国的数据安全法规、个人隐私保护法规都日趋完善,开发AI大模型首要解决合法的数据来源问题。这个合法渠道的数据生成还必须要有规模化。

这一点,就首先赋予了大型科技企业的“先发优势”。

百度的搜索数据,阿里的电商数据,科大讯飞和商汤科技基于应用场景的行业数据,都已经分别在各自领域成为领袖企业,天然具备了数据获取的“护城河”。

例如在医疗领域,据科大讯飞董事长刘庆峰发言透露,目前讯飞的智医助理在全国已累计提供辅助诊断5亿多次,每天可以帮助基层医生看70多万病人,此外还与协和、安徽省立医院等众多医院建立了合作。

只有自己拥有合法、可靠、合规的数据来源,才能在AI大模型竞争中有基本的入场券。

2、算力

ChatGPT可能是迄今为止最吃算力的应用。

据中信建投研报数据,此前用于AI训练的算力增长符合摩尔定律,大约每20个月翻一番;深度学习的出现加速了性能的扩展,用于AI训练的算力大约每6个月翻一番;而目前大规模模型出现,其训练算力是原来的10到100倍。

自2012年起,全球头部AI模型训练算力需求每3-4个月翻一番,每年头部训练模型所需算力增长幅度高达10倍, GPT-3训练成本预计在500万美元/次。

国信证券测算称,引用OneFlow的测算结果,在公有云中训练OPEN AI的GPT-3模型需花费训练成本约140万美元,Google的PaLM模型需花费训练成本约1120万美元。

推理成本方面,国信证券称为满足当前用户访问产生的推理成本,自建IDC初始投入约在4亿美元,租用云服务每日成本约28万美元。

根据商汤科技官网,2022年1月24日商汤AIDC启动运营,该项目占地面积约5.8万平方米,总投资约56亿元,项目全部建成后AI计算峰值速度将达到3740Pflops。

以商汤AIDC为计算参考,每新建1Eflops算力需要投资15亿元,其中ICT硬件投资占比72%。则活跃人数每增加1亿人需要新增投资203亿元,其中ICT硬件投资146亿元。

假设未来有6家科技巨头能够在未来3年内各自拥有一款活跃人数2亿的ChatGPT类应用,则未来3年ICT硬件投资将新增需求1755亿元。若考虑到AIGC技术向音频、视频等方向蔓延,算力需求提升幅度将更为显著。

如此庞大的投资强度,对于事先没有在云计算领域、AI计算领域做部署的和新入场企业来说,绝对是巨大的资金压力。

3、场景

AI大模型,目前在中国的主要应用场景,是“拉股价”。

但是当喧嚣过后,终究丑媳妇要见公婆。例如某几个上市公司,此前用AI大模型概念股价狂涨,但是当证券会问询函一到,很快就显出原形,只剩下韭菜们在风中凌乱。

从2020年GPT-3模型发布以后,国内大概成立了100多家相关应用公司,大概86%的公司都在做生产率工具,做文字总结归纳,以及多模态图像生成、视频生成。项目很多,雷同度很高,底层创新很少。

因为说到实际,请问一下,有多少人会无聊到和AI斗智斗勇聊天,有多少人会需要每天生成几十个图片供选择,又有多少人需要用AI写PPT写报告?------特别是那些希望借助AI做文案、做图片和做报告的人,AI永远没有你更了解上级老板想喝什么茶,以及知道他/她的品味有多低。

因此,至少在中国可见的未来,真正的应用场景是政企,即G和B。

G端的AI大模型需求基本一致,但是需要数据部署本地化,以形成闭环保密,这代表着开发的投入可以多次重复售卖----这就是传统科技企业的起家之本玩法。

B端的AI大模型需求需要定制,因为可以显著降本增效,因此愿意支付具有利润空间的溢价。而行业内企业之间的底层共性,又能节约研发成本。

例如百度大模型是在电力、燃气、金融、航天等领域,华为则是有盘谷气象、盘谷矿山、盘谷OCR等。

最关键的是,这两个群体,才是真的有钱,且愿意付钱。

虽然在C端,例如科大讯飞的学习机已经完全可以代替家长在家实现补课、批改,但是讯飞的教育业务最大场景客户还是基于B端的学校智慧教育方案。

因此,当科大讯飞开放平台宣布将联合首批接入的36个行业、3000余家企业开发者,共建大模型行业通用解决方案,这才是真正有意义的星火,假以时日,必能燎原。

关于中国的AI大模型前景,你怎么看?

作者/张栋伟(资深互联网人士,市场营销专家,大学生就业创业导师)

原文标题 : 张栋伟:讯飞的星火,能否燎原AI大模型?

最新活动更多

-

3月27日立即报名>> 【工程师系列】汽车电子技术在线大会

-

4月30日立即下载>> 【村田汽车】汽车E/E架构革新中,新智能座舱挑战的解决方案

-

5月15-17日立即预约>> 【线下巡回】2025年STM32峰会

-

即日-5.15立即报名>>> 【在线会议】安森美Hyperlux™ ID系列引领iToF技术革新

-

5月15日立即下载>> 【白皮书】精确和高效地表征3000V/20A功率器件应用指南

-

5月16日立即参评 >> 【评选启动】维科杯·OFweek 2025(第十届)人工智能行业年度评选

分享

分享

发表评论

请输入评论内容...

请输入评论/评论长度6~500个字

暂无评论

暂无评论