英伟达也搞起大模型?半导体行业迎来大挑战,这回是为了芯片设计

因为AI对算力的庞大需求,市面上的高算力GPU一直是各方争抢的香饽饽,而英伟达也因此赚得盆满钵满。不过现在英伟达又动起了别的心思。

自己作为GPU厂商,为什么不下场做大模型呢?近日,英伟达推出了自家的全新大模型——ChipNeMo,号称拥有430亿参数。

专为芯片设计而生的大模型

据英伟达官方表示,ChipNeMo专注于辅助芯片设计,旨在提高工程师的工作效率。这一大语言模型的应用范围广泛,包括问答、EDA脚本生成和Bug总结等任务,使芯片设计变得更加便捷。

图源:站长之家

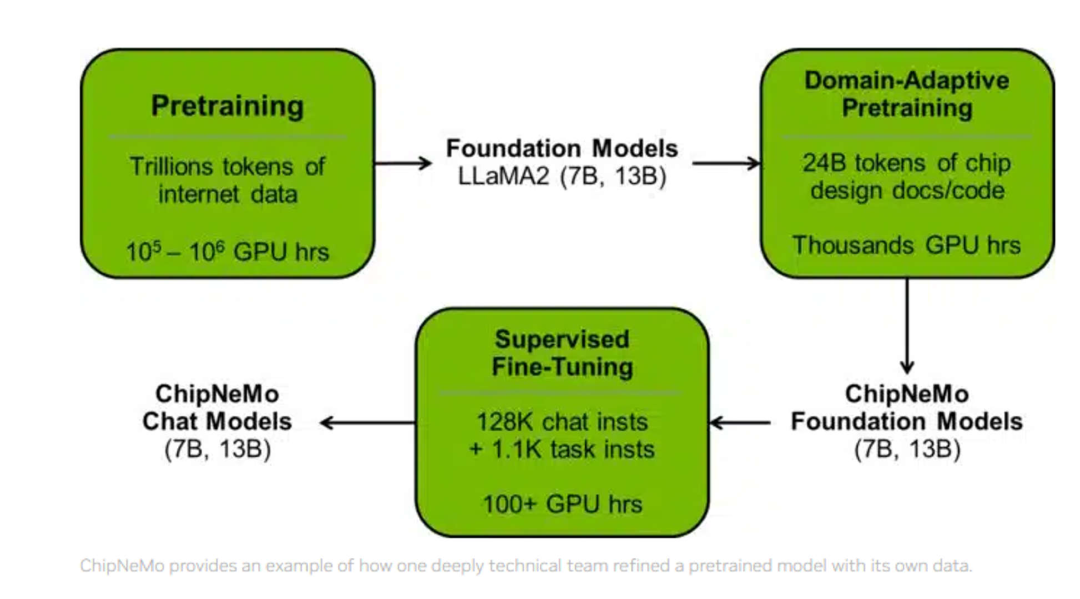

研究人员并没有直接部署现成的商业或开源LLM,而是采用了以下领域适应技术:自定义分词器、领域自适应持续预训练(DAPT)、具有特定领域指令的监督微调(SFT),以及适应领域的检索模型。

结果表明,与通用基础模型相比(如拥有700亿个参数的Llama 2),这些领域适应技术能够显著提高LLM的性能。

英伟达首席科学家Bill Dally强调,即使提高生产率的幅度不大,使用ChipNeMo仍然是值得的。ChipNeMo的数据集包括Bug总结、设计源、文档以及硬件相关的代码和自然语言文本,经过数据采集、清洗和过滤后,共有241亿个token。

英伟达采用了领域自适应技术,包括自定义标记器、领域自适应持续预训练、带有领域特定指令的监督微调等方法,以提升大语言模型在工程助理聊天机器人、EDA脚本生成和Bug摘要和分析等领域的性能。

结果显示,这些领域自适应技术不仅提高了性能,还减小了模型大小,但仍有改进空间。英伟达的这一举措标志着大语言模型在半导体设计领域的应用迈出了重要的一步,为专业化领域提供了有用的生成式AI模型。

针对大模型的幻觉问题,研究人员选择了检索增强生成(RAG)的方法。研究人员发现,在RAG中使用与领域相适应的语言模型可以显著提高特定领域问题的答案质量。

此外,使用适量的特定领域训练数据对现成的无监督预训练稠密检索模型进行微调,可显著提高检索准确率。

用AI设计芯片,将是未来?

实际上,包括英伟达在内的诸多科技企业或研发机构很早就在尝试利用AI来设计芯片。今年6月,纽约大学Tandon工程学院的研究人员就通过GPT-4造出了一个芯片。研究人员利用GPT-4仅用19轮对话,就造出了130nm芯片,并通过了Skywater 130nm穿梭机的流片测试。

图源:机核

2022年4月,英伟达首席科学家Bill Dall公开了内部的重点研究与工作项目,提到其目标是利用人工智能来改进自己的产品,比如在其GPU产品设计工作中,大量采用人工智能辅助,来加速以及最佳化GPU芯片的设计,相关设计甚至涉及供电模拟设计、从电路到GPU规模的大型积体电路设计、架构网络以及储存系统管理等。

同时,英伟达依托人工智能芯片设计工具,可以根据标准的处理单元布局来自动产生芯片的设计图,也可以用来检验人类员工设计出来的芯片布局中有无错误。据Bill Dally当时的说法,这套工具只需要在配备两个GPU的平台上,短短几天的时间,就可以超过一组十人员工一年的工作份量。

今年3月,英伟达也推出了四款推理平台。这些平台针对各种快速兴起的生成式AI应用进行优化,能够帮助开发人员快速构建用于提供新服务和洞察的 AI 驱动的专业应用。这些平台可以将NVIDIA全栈推理软件与最新的 NVIDIA Ada、Hopper 和 Grace Hopper 处理器相结合,针对AI视频、图像生成、大型语言模型部署、推荐系统推理等需求激增的工作负载进行优化。

除了英伟达之外,微软、谷歌、ARM、Cadence和Synopsys等公司和机构都在利用AI技术进行芯片设计,以提高芯片设计的效率和精度。

例如,谷歌利用AI技术设计出了专门针对图像和视频处理的张量处理单元(TPU)芯片,该芯片在谷歌云平台上的TensorFlow框架中使用,为机器学习任务提供了高性能的计算支持。

此外,微软研究院也利用AI技术设计出了一种基于Transformer模型的神经芯片,该芯片可以并行处理多个计算任务,提高芯片的计算效率和能效。

最新活动更多

-

3月27日立即报名>> 【工程师系列】汽车电子技术在线大会

-

4月30日立即下载>> 【村田汽车】汽车E/E架构革新中,新智能座舱挑战的解决方案

-

5月15-17日立即预约>> 【线下巡回】2025年STM32峰会

-

即日-5.15立即报名>>> 【在线会议】安森美Hyperlux™ ID系列引领iToF技术革新

-

5月15日立即下载>> 【白皮书】精确和高效地表征3000V/20A功率器件应用指南

-

5月16日立即参评 >> 【评选启动】维科杯·OFweek 2025(第十届)人工智能行业年度评选

分享

分享

发表评论

请输入评论内容...

请输入评论/评论长度6~500个字

暂无评论

暂无评论