本文重点要讲的这篇论文是: ·Unifying Language Learning Paradigm...

近年来,以超大规模模型、海量训练数据、自监督学习准则为特点的无监督预训练模型备受关注。具有高通用性的无监督预训练大模型,结合知识和海量数据进行融合学习,通过提取原始数据的...

近年来,以超大规模模型、海量训练数据、自监督学习准则为特点的无监督预训练模型备受关注。具有高通用性的无监督预训练大模型,结合知识和海量数据进行融合学习,通过提取原始数据的...

最近和同事聊天,聊到一次面试时,同事作为面试官,提问了一个小问题:「如果你拥有的预训练的语料和下游任务的语料分布差异很大,你会怎么做」「那他答上来了吗」我问到「没有」他说...

近日,OPPO小布助手团队和机器学习部联合完成了十亿参数模型“OBERT”的预训练,业务上取得了4%以上的提升;在行业对比评测中,OBERT跃居中文语言理解测评基准CLU...

近日,OPPO小布助手团队和机器学习部联合完成了十亿参数模型“OBERT”的预训练,业务上取得了4%以上的提升;在行业对比评测中,OBERT跃居中文语言理解测评基准CLU...

今日,北京电子工程总体研究所发布“虚拟孪生-元宇宙协同建模仿真方法研究”的军工需求公告,采购阶段为预研。根据公告,上述项目的研究目标为:针对元宇宙、虚拟孪生等新型虚拟环境...

今日,北京电子工程总体研究所发布“虚拟孪生-元宇宙协同建模仿真方法研究”的军工需求公告,采购阶段为预研。根据公告,上述项目的研究目标为:针对元宇宙、虚拟孪生等新型虚拟环境...

目录一、为什么要mask二、这些年paper中出现过的mask方式2.1 padding Padding-mask2.2 sequence mask:transforme...

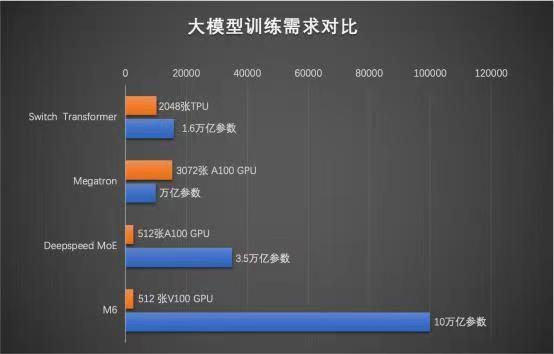

近日,阿里巴巴达摩院公布多模态大模型 M6 最新进展,其参数已从万亿跃迁至 10 万亿,成为全球最大的 AI 预训练模型。据公开资料显示,M6 是达摩院研发的通用性人工智...

11月8日消息,阿里巴巴达摩院公布多模态大模型M6最新进展,其参数已从万亿跃迁至10万亿,规模远超谷歌、微软此前发布的万亿级模型,成为全球最大的AI预训练模型。同时,M6...

11月8日消息,阿里巴巴达摩院公布多模态大模型M6最新进展,其参数已从万亿跃迁至10万亿,规模远超谷歌、微软此前发布的万亿级模型,成为全球最大的AI预训练模型。同时,M6...

自2018年谷歌发布BERT以来,预训练大模型经过三年的发展,以强大的算法效果,席卷了NLP为代表的各大AI榜单与测试数据集。2020年OpenAI发布的NLP大模型GP...

概要分享我的知识,使用带有示例代码片段的迁移学习逐步在Google colab中的自定义数据集上训练StyleGAN如何使用预训练的权重从自定义数据集中生成图像使用不同的...

论文标题:AMBERT: A Pre-trained Language Model with Multi-Grained Tokenization(多粒度分词的预训练语言...

为了充分研究大规模预训练和迁移学习的内在机理和规律,来自谷歌的研究人员发表了一篇名为BigTransfer的论文,探索了如何有效利用超常规的图像数据规模来对模型进行预训练...

就在谷歌、三星和微软继续在个人电脑和移动设备上大力推广人工智能生成技术的同时,苹果也加入了这一行列,推出了OpenELM。 这是一个全新的开源大型语言模型(LLM)系列...

Naveen Rao已经在建立人工智能技术和公司方面有十多年的经验。他创立了 Nervana Systems(被英特尔收购)和 MosaicML(被Databricks收...

作者:小岩 编辑:彩云 4月19日,Facebook母公司Meta重磅推出了Llama3。 即便大家现在对于大厂和巨头频繁迭代AI模型的行为已经见怪不怪,Meta的...

作者|昭觉 AI新星OpenAI最近有点头疼,不仅公司和CEO被马斯克起诉,其拳头产品GPT-4在性能和价格上均面临竞争对手的冲击。 近期,成立不到一年的法国人工智能...

作者 |毫末智行数据智能科学家 贺翔编辑 |祥威最近,特斯拉FSD V12的发布引发了业界对端到端自动驾驶的热议,业界纷纷猜测FSD V12的强大能力是如何训练出来的。从...

“元宇宙的开拓者”是我们针对元宇宙的发展而设立的专栏,主要面向那些深挖元宇宙产业或者在元宇宙进行“淘金”的从业者,分享这些...

作者 |张祥威 编辑 |德新 2023年,在比亚迪那次公布智驾数据规模后,智能化下半场的战斗就正式打响了。 如今,自动驾驶正在沿着特斯拉提出的「BEV+Tran...

12月谷歌的大语言模型Gemini一经发布就引发行业热议。在多个大模型评测榜单中,谷歌Gemini Ultra版本超过了GPT-4,已有成为大模型“新王&rd...

为积极响应工信部等十七部门联合印发的《“机器人+”应用行动实施方案》,推动“机器人+ ...

文档来源:利元亨