机器学习:开启智能创新之门

2.无监督学习(Unsupervised Learning)

给学习算法提供的数据是未标记的,并且要求算法识别输入数据中的模式,主要是建立一个模型,用其试着对输入的数据进行解释,并用于下次输入。现实情况下往往很多数据集都有大量的未标记样本,有标记的样本反而比较少。如果直接弃用,很大程度上会导致模型精度低。这种情况解决的思路往往是结合有标记的样本,通过估计的方法把未标记样本变为伪的有标记样本,所以无监督学习比监督学习更难掌握。主要用于解决聚类和降维问题,常见的算法有:

(1)聚类算法:把一组对象分组化的任务,使得在同一组的对象比起其它组的对象,它们彼此更加相似。常用的聚类算法包括:

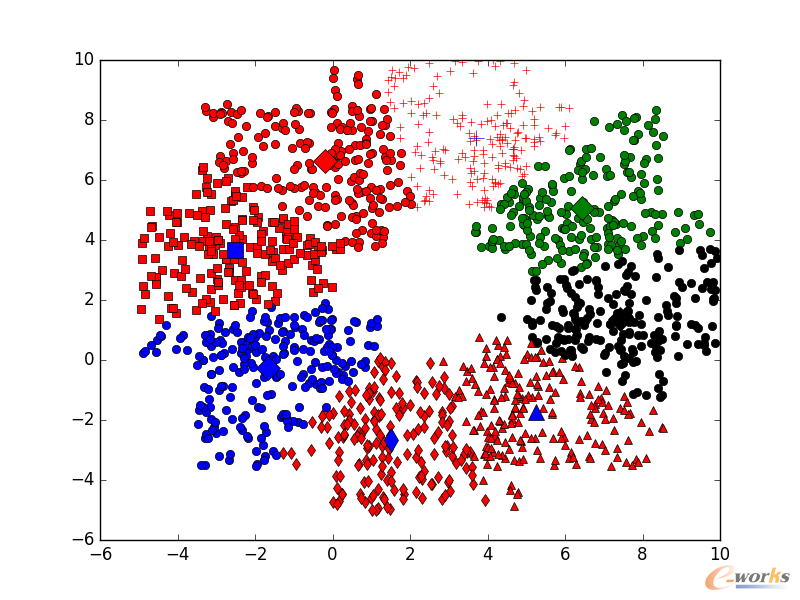

①K-means算法:这是典型的基于原型的目标函数聚类方法的代表,它是数据点到原型的某种距离作为优化的目标函数,利用函数求极值的方法得到迭代运算的调整规则。其优点是算法足够快速、简单,并且如果预处理数据和特征工程十分有效,那么该聚类算法将拥有极高的灵活性。缺点是该算法需要指定集群的数量,而K值的选择通常都不是那么容易确定的。另外,如果训练数据中的真实集群并不是类球状的,那么K均值聚类会得出一些比较差的集群。

图15 K-means算法

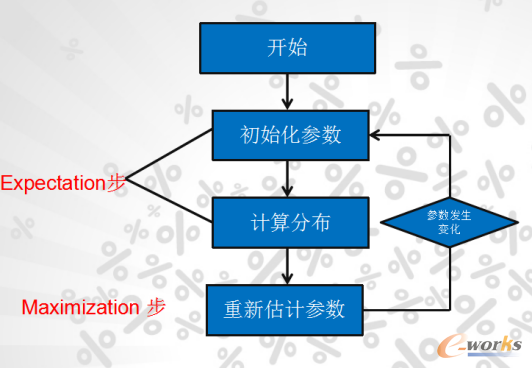

②Expectation Maximisation (EM):这是一种迭代算法,用于含有隐变量(latent variable)的概率参数模型的最大似然估计或极大后验概率估计。EM算法的主要目的是提供一个简单的迭代算法计算后验密度函数,它的最大优点是简单和稳定,但容易陷入局部最优。

图16 EM算法

③Affinity Propagation 聚类:AP 聚类算法是一种相对较新的聚类算法,该聚类算法基于两个样本点之间的图形距离(graph distances)确定集群。采用该聚类方法的集群拥有更小和不相等的大小。优点:该算法不需要指出明确的集群数量。缺点:AP 聚类算法主要的缺点就是训练速度比较慢,并需要大量内存,因此也就很难扩展到大数据集中。另外,该算法同样假定潜在的集群是类球状的。

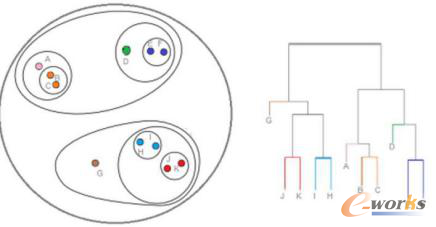

④层次聚类(Hierarchical Clustering):层次聚类是一系列基于以下概念的聚类算法:是通过对数据集按照某种方法进行层次分解,直到满足某种条件为止。按照分类原理的不同,可以分为凝聚和分裂两种方法。优点:层次聚类最主要的优点是集群不再需要假设为类球形。另外其也可以扩展到大数据集。缺点:有点像 K 均值聚类,该算法需要设定集群的数量。

图17 层次聚类算法

⑤DBSCAN:这是一个比较有代表性的基于密度的聚类算法。与划分和层次聚类方法不同,它将簇定义为密度相连的点的最大集合,能够把具有足够高密度的区域划分为簇,并可在噪声的空间数据库中发现任意形状的聚类。它将样本点的密集区域组成一个集群。优点:DBSCAN 不需要假设集群为球状,并且它的性能是可扩展的。此外,它不需要每个点都被分配到一个集群中,这降低了集群的异常数据。缺点:用户必须要调整「epsilon」和「min_sample」这两个定义了集群密度的超参数。DBSCAN 对这些超参数非常敏感。

图18 DBSCAN算法

(2)降维算法:其主要特征是将数据从高维降低到低维层次,最大程度的保留了数据的信息。代表算法是:

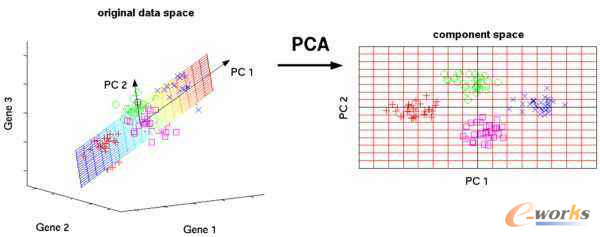

①主要代表是主成分分析算法(PCA算法):主成分分析也称主分量分析,旨在利用降维的思想,把多指标转化为少数几个综合指标(即主成分),其中每个主成分都能够反映原始变量的大部分信息,且所含信息互不重复。这种方法在引进多方面变量的同时将复杂因素归结为几个主成分,使问题简单化,同时得到的结果更加科学有效的数据信息。

图19 PCA算法

②局部线性嵌入(Locally linear embeddingLLE)LLE降维算法:一种非线性降维算法,它能够使降维后的数据较好地保持原有 流形结构 。该算法是针对非线性信号特征矢量维数的优化方法,这种维数优化并不是仅仅在数量上简单的约简,而是在保持原始数据性质不变的情况下,将高维空间的信号映射到低维空间上,即特征值的二次提取。

图20 LLE降维算法

3.强化学习(Reinforcement Learning)

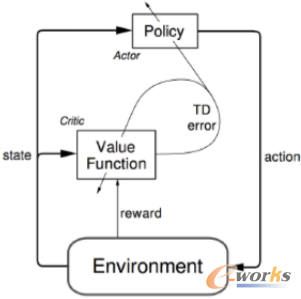

该算法与动态环境相互作用,把环境的反馈作为输入,通过学习选择能达到其目标的最优动作。强化学习这一方法背后的数学原理与监督/非监督学习略有差异。监督/非监督学习更多地应用了统计学,而强化学习更多地结合了离散数学、随机过程这些数学方法。常见的算法有:

①TD(λ)算法:TD(temporal differenee)学习是强化学习技术中最主要的学习技术之一.TD学习是蒙特卡罗思想和动态规划思想的结合,即一方面TD算法在不需要系统模型情况下可以直接从agent经验中学习;另一方面TD算法和动态规划一样,利用估计的值函数进行迭代。

图21 TD(λ)算法

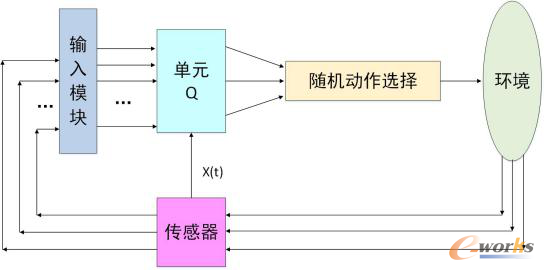

②Q_learning算法:Q_learning学习是一种模型无关的强化学习算法 ,又称为离策略TD学习(off-policy TD).不同于TD算法,Q_learning迭代时采用状态_动作对的奖赏和Q (s,a)作为估计函数,在Agent每一次学习迭代时都需要考察每一个行为,可确保学习过程收敛。

图22 Q_learning算法

分享

分享

发表评论

请输入评论内容...

请输入评论/评论长度6~500个字

暂无评论

暂无评论